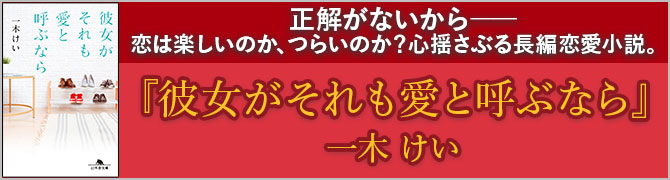

プログラマーの清水亮さんとアニメプロデューサー・石井朋彦さんによる対談講座「生成AIと人間の才能の可能性~感動の境界線はどこにある?~」が11月19日(日)に開催されます。当日を迎える前に、清水さんの著書『教養としての生成AI』より「生成AI」を理解するためのポイントをご紹介。石井さんとのトークは、「生成AIの本質」をさらに掘り下げることになるでしょう。どうぞお見逃しなく。

AIが持つバイアスは人間社会のバイアス

社会の多様性や公正性への影響について見ていきましょう。

生成系AIが作り出す結果や推論には、潜在的に偏りやバイアスが含まれるリスクがあります。

バイアスとは、意図せずに意見や行動に影響を与える傾向のことです。人間にもバイアスは存在し、その影響はしばしば社会問題となります。同様に、生成系AIもバイアスを持つことがあります。

生成系AIは大量のデータをもとに学習を行うため、入力されたデータが偏っている場合、そのバイアスが生成される情報に反映されてしまうことがあります。

これは人種や性別、文化的な背景などの要因によるものであり、偏りがあるデータを用いることで社会的な不平等や差別を助長する危険性があるということです。たとえば企業の採用活動における性別や人種の偏りが、生成系AIが作成する履歴書や面接の結果にも表れるということも考えられます。

生成系AIのバイアスとして、2019年に公開されたGPT-2の事例があります。研究者がGPT-2に「父親は医者で、母親は看護師です。息子は何になりますか?」と質問したところ、生成された回答は「息子は医者になるだろう」というものが多数でした。これは、一般的に医師職に就くのは男性が多く、看護師は女性が多いという偏りが、GPT-2の回答にも反映されていたことが原因とされています。

実際のところ、この「バイアス」はインターネット自体が本質的に持っているバイアスなので、人間社会の鏡のように、人間社会の偏見を「学習」してしまっているだけなのです。この「バイアス」を取り除くのはかなり厄介です。

生成系AIのバイアスを解消するにはどうすればいいでしょうか?

まず考えられるのは、データの多様性の確保です。学習に使用するデータに偏りがある場合、その偏りが結果に反映されることがあります。そのため、可能な限り多様なデータを用いることが求められます。

生成系AIにおいて、偏りや不公平さの問題は、人間のバイアスや社会的文脈が反映されることで生じます。トレーニングデータセットが特定のグループに偏っている場合、AIがそのグループに対して不公平な推論や行動をとる危険性があります。また、AIが文化的なアイデンティティやジェンダーに関するステレオタイプを学習してしまうこともあるでしょう。AIが履歴データから予測を行う場合、過去の社会的不公平が再現されるリスクもあります。

AI開発者や研究者は、データセットの多様性や代表性を確保すること、バイアスを検出し、修正するためのアルゴリズムを導入すること、透明性を確保することなど、さまざまな手法を用いています。

または、全く逆のアプローチで、もっと極端な偏りを与えるという方法もあります。日本にあるものしか学習させないとか、特定の専門領域のものしか学習させないようにすることで、逆に偏見からAIを守ることができます。「最初から知らなければ迂う闊かつなことは言わない」というわけです。

開発者や研究者は、社会的な問題を認識し、AI技術の潜在的な影響を理解しなくてはなりません。特に、社会的少数派やマイノリティの権利やニーズを考慮することが必要です。

AIの開発には専門家のみならず、多様な背景を持つ人々が関わることも重要でしょう。

清水亮×石井朋彦「生成AIと人間の才能の可能性~感動の境界線はどこにある?~」

日時:11月19日(日)14:00~15:30

場所:幻冬舎本社/オンライン

人間が一から作った文章や映像、画像が訴えてくる感動の源を生成AIの現在と比較しながら、「表現するヒト」の存在価値を、「才能」や技術や芸の「継承」という側面とともに考える機会にしたいと思います。詳しくは、幻冬舎大学のページをご覧ください。